teorías atómicas:

En física y química, la teoría atómica es una teoría de la naturaleza de la materia, que afirma que está compuesta por pequeñas partículas llamadas átomos.

El primero en proponer una teoría atómica de la materia fue Demócrito, filósofo presocrático, quien en el siglo V a. C. afirmó que todo estaba compuesto por pequeñas piezas a las que llamó átomos (del griego ἄτομον, indivisible). Su teoría fue prontamente olvidada. Recién en el siglo XIX tal idea logró una extensa aceptación científica gracias a los descubrimientos en el campo de la estequiometría. Los químicos de la época creían que las unidades básicas de los elementos también eran las partículas fundamentales de la naturaleza (de ahí el nombre de átomo, «indivisible»). Sin embargo, a finales de aquel siglo, y mediante diversos experimentos con el electromagnetismo y la radiactividad, los físicos descubrieron que el denominado "átomo indivisible" era realmente un conglomerado de diversas partículas subatómicas (principalmente electrones, protones y neutrones), que pueden existir de forma aislada. De hecho, en ciertos ambientes, como en las estrellas de neutrones, la temperatura extrema y la elevada presión impide a los átomos existir como tales. El campo de la ciencia que estudia las partículas fundamentales de la materia se denomina física de partículas.

Teoría atómica de Dalton

Durante el siglo XVIII y los primeros años del siglo XIX, en su afán por conocer e interpretar la naturaleza, los científicos estudiaron intensamente las reacciones químicas mediante numerosos experimentos. Estos estudios permitieron hallar relaciones muy precisas entre las masas de las sustancias sólidas o entre los volúmenes de los gases que intervienen en las reacciones químicas. Las relaciones encontradas se conocen como leyes de la química. Entre las leyes fundamentales de la Química, hay algunas que establecen las relaciones entre masas, llamadas leyes gravimétricas y otras que relacionan volúmenes, denominadas leyes volumétricas. John Dalton desarrolló su modelo atómico, en la que proponía que cada elemento químico estaba compuesto por átomos iguales y exclusivos, y que aunque eran indivisibles e indestructibles, se podían asociar para formar estructuras más complejas (los compuestos químicos). Esta teoría tuvo diversos precedentes.El primero fue la ley de conservación de la masa, formulada por Antoine Lavoisier en 1789, que afirma que la masa total en una reacción química permanece constante. Esta ley le sugirió a Dalton la idea de que la materia era indestructible.

El segundo fue la ley de las proporciones definidas. Enunciada por el químico francés Joseph Louis Proust en 1799, afirma que, en un compuesto, los elementos que lo conforman se combinan en proporciones de masa definidas y características del compuesto.

Dalton estudió y amplió el trabajo de Proust para desarrollar la ley de las proporciones múltiples: cuando dos elementos se combinan para originar diferentes compuestos, dada una cantidad fija de uno de ellos, las diferentes cantidades del otro se combinan con dicha cantidad fija para dar como producto los compuestos, están en relación de números enteros sencillos.

En 1803, Dalton publicó su primera lista de pesos atómicos relativos para cierta cantidad de sustancias. Esto, unido a su rudimentario material, hizo que su tabla fuese muy poco precisa. Por ejemplo, creía que los átomos de oxígeno eran 5,5 veces más pesados que los átomos de hidrógeno, porque en el agua midió 5,5 gramos de oxígeno por cada gramo de hidrógeno y creía que la fórmula del agua, en estado gaseoso, era HO (en realidad, un átomo de oxígeno es 16 veces más pesado que un átomo de hidrógeno).

La ley de Avogadro permitió deducir la naturaleza diatómica de numerosos gases, estudiando los volúmenes en los que reaccionaban. Por ejemplo: el hecho de que dos litros de hidrógeno reaccionasen con un litro de oxígeno para producir dos litros de vapor de agua (a presión y temperatura constantes), significaba que una única molécula de oxígeno se divide en dos para formar dos partículas de agua. De esta forma, Avogadro podía calcular estimaciones más exactas de la masa atómica del oxígeno y de otros elementos, y estableció la distinción entre moléculas y átomos.

Ya en 1784, el botánico escocés Robert Brown, había observado que las partículas de polvo que flotaban en el agua se movían al azar sin ninguna razón aparente. En 1905, Albert Einstein tenía la teoría de que este movimiento browniano lo causaban las moléculas de agua que "bombardeaban" constantemente las partículas, y desarrolló un modelo matemático hipotético para describirlo. El físico francés Jean Perrin demostró experimentalmente este modelo en 1911, proporcionando además la validación a la teoría de partículas (y por extensión, a la teoría atómica).

Descubrimiento de las partículas subatómicas

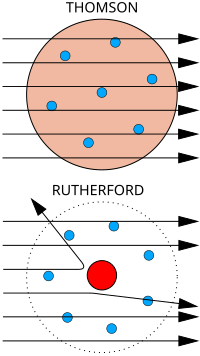

Thomson creía que los corpúsculos surgían de los átomos del electrodo. De esta forma, estipuló que los átomos eran divisibles, y que los corpúsculos eran sus componentes. Para explicar la carga neutra del átomo, propuso que los corpúsculos se distribuían en estructuras anilladas dentro de una nube positiva uniforme; éste era el modelo atómico de Thomson o "modelo del plum cake".2

Ya que se vio que los átomos eran realmente divisibles, los físicos inventaron más tarde el término "partículas elementales" para designar a las partículas indivisibles.

Descubrimiento del núcleo

Arriba: Resultados esperados: las partículas alfa pasan sin problemas por el modelo atómico de Thomson.

Abajo: Resultados observados: una pequeña parte de las partículas se desvía, lo que revela la existencia de un lugar en el átomo donde se concentra la carga positiva.

En su experimento, Hans Geiger y Ernest Marsden bombardearon partículas alfa a través de una fina lámina de oro (que chocarían con una pantalla fluorescente que habían colocado rodeando la lámina).3 Dada la mínima como masa de los electrones, la elevada masa y momento de las partículas alfa y la distribución uniforme de la carga positiva del modelo de Thomson, estos científicos esperaban que todas las partículas alfa atravesasen la lámina de oro sin desviarse, o por el contrario, que fuesen absorbidas. Para su asombro, una pequeña fracción de las partículas alfa sufrió una fuerte desviación. Esto indujo a Rutherford a proponer el modelo planetario del átomo, en el que los electrones orbitaban en el espacio alrededor de un gran núcleo compacto, a semejanza de los planetas y el Sol.4

Descubrimiento de los isótopos

En 1913, Thomson canalizó una corriente de iones de neón a través de campos magnéticos y eléctricos, hasta chocar con una placa fotográfica que había colocado al otro lado. Observó dos zonas incandescentes en la placa, que revelaban dos trayectorias de desviación diferentes. Thomson concluyó que esto era porque algunos de los iones de neón tenían diferentes masas; así fue como descubrió la existencia de los isótopos.5Descubrimiento del neutrón

Véase también: Neutrón#Historia

En 1918,

Rutherford logró partir el núcleo del átomo al bombardear gas nitrógeno

con partículas alfa, y observó que el gas emitía núcleos de hidrógeno.

Rutherford concluyó que los núcleos de hidrógeno procedían de los

núcleos de los mismos átomos de nitrógeno.6

Más tarde descubrió que la carga positiva de cualquier átomo equivalía

siempre a un número entero de núcleos de hidrógeno. Esto, junto con el

hecho de que el hidrógeno —el elemento más ligero— tenía una masa

atómica de 1, le llevó a afirmar que los núcleos de hidrógeno eran

partículas singulares, constituyentes básicos de todos los núcleos

atómicos: se había descubierto el protón.

Un experimento posterior de Rutherford mostró que la masa nuclear de la

mayoría de los átomos superaba a la de los protones que tenía. Por

tanto, postuló la existencia de partículas sin carga, hasta entonces

desconocidas más tarde llamadas neutrones, de donde provendría este

exceso de masa.En 1928, Walther Bothe observó que el berilio emitía una radiación eléctricamente neutra cuando se le bombardeaba con partículas alfa. En 1932, James Chadwick expuso diversos elementos a esta radiación y dedujo que ésta estaba compuesta por partículas eléctricamente neutras con una masa similar la de un protón.7 Chadwick llamó a estas partículas "neutrones".

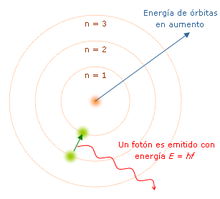

Modelos cuánticos del átomo

El modelo planetario del átomo tenía sus defectos. En primer lugar, según la fórmula de Larmor del electromagnetismo clásico, una carga eléctrica en aceleración emite ondas electromagnéticas, y una carga en órbita iría perdiendo energía y describiría una espiral hasta acabar cayendo en el núcleo. Otro fenómeno que el modelo no explicaba era por qué los átomos excitados sólo emiten luz con ciertos espectros discretos.El modelo de Bohr-Sommerfeld ad hoc era muy difícil de utilizar, pero a cambio hacía increíbles predicciones de acuerdo con ciertas propiedades espectrales. Sin embargo, era incapaz de explicar los átomos multielectrónicos, predecir la tasa de transición o describir las estructuras finas e hiperfinas.

En 1924, Louis de Broglie propuso que todos los objetos —particularmente las partículas subatómicas, como los electrones— podían tener propiedades de ondas. Erwin Schrödinger, fascinado por esta idea, investigó si el movimiento de un electrón en un átomo se podría explicar mejor como onda que como partícula. La ecuación de Schrödinger, publicada en 1926,10 describe al electrón como una función de onda en lugar de como una partícula, y predijo muchos de los fenómenos espectrales que el modelo de Bohr no podía explicar. Aunque este concepto era matemáticamente correcto, era difícil de visualizar, y tuvo sus detractores.11 Uno de sus críticos, Max Born, dijo que la función de onda de Schrödinger no describía el electrón, pero sí a muchos de sus posibles estados, y de esta forma se podría usar para calcular la probabilidad de encontrar un electrón en cualquier posición dada alrededor del núcleo.12

En 1927, Werner Heisenberg indicó que, puesto que una función de onda está determinada por el tiempo y la posición, es imposible obtener simultáneamente valores precisos tanto para la posición como para el momento de la partícula para cualquier punto dado en el tiempo.13 Este principio fue conocido como principio de incertidumbre de Heisenberg.

Los cinco orbitales atómicos de un átomo de

neón, separados y ordenados en orden creciente de energía. En cada

orbital caben como máximo dos electrones, que están la mayor parte del

tiempo en las zonas delimitadas por las "burbujas".

como orbitales atómicos.

RELATIVIDAD:

La teoría de la relatividad incluye tanto a la teoría de la relatividad especial y como a la relatividad general, formuladas por Albert Einstein a principios del siglo XX, que pretendían resolver la incompatibilidad existente entre la mecánica newtoniana y el electromagnetismo.

La teoría de la relatividad especial, publicada en 1905, trata de la física del movimiento de los cuerpos en ausencia de fuerzas gravitatorias, en el que se hacían compatibles las ecuaciones de Maxwell del electromagnetismo con una reformulación de las leyes del movimiento.

La teoría de la relatividad general, publicada en 1915, es una teoría de la gravedad que reemplaza a la gravedad newtoniana, aunque coincide numéricamente con ella para campos gravitatorios débiles y "pequeñas" velocidades. La teoría general se reduce a la teoría especial en ausencia de campos gravitatorios.

No fue hasta el 7 de marzo de 2010 cuando fueron mostrados públicamente los manuscritos originales de Einstein por parte de la Academia Israelí de Ciencias, aunque la teoría se había publicado en 1905. El manuscrito contiene 46 páginas de textos y fórmulas matemáticas redactadas a mano, y fue donado por Einstein a la Universidad Hebrea de Jerusalén en 1925 con motivo de su inauguración.1 2 3

Conceptos principales

.

.Relatividad especial

La teoría de la relatividad especial, también llamada teoría de la relatividad restringida, fue publicada por Albert Einstein en 1905 y describe la física del movimiento en el marco de un espacio-tiempo plano. Esta teoría describe correctamente el movimiento de los cuerpos incluso a grandes velocidades y sus interacciones electromagnéticas y se usa básicamente para estudiar sistemas de referencia inerciales (no es aplicable para problemas astrofísicos donde el campo gravitatorio desempeña un papel importante).Estos conceptos fueron presentados anteriormente por Poincaré y Lorentz, que son considerados como precursores de la teoría. Si bien la teoría resolvía un buen número de problemas del electromagnetismo y daba una explicación del experimento de Michelson-Morley, no proporciona una descripción relativista adecuada del campo gravitatorio.

Tras la publicación del artículo de Einstein, la nueva teoría de la relatividad especial fue aceptada en unos pocos años por la práctica totalidad de los físicos y los matemáticos. De hecho, Poincaré o Lorentz habían estado muy cerca de llegar al mismo resultado que Einstein. La forma geométrica definitiva de la teoría se debe a Hermann Minkowski, antiguo profesor de Einstein en la Politécnica de Zürich; acuñó el término "espacio-tiempo" (Raumzeit) y le dio la forma matemática adecuada.nota 1 El espacio-tiempo de Minkowski es una variedad tetradimensional en la que se entrelazaban de una manera insoluble las tres dimensiones espaciales y el tiempo. En este espacio-tiempo de Minkowski, el movimiento de una partícula se representa mediante su línea de universo (Weltlinie), una curva cuyos puntos vienen determinados por cuatro variables distintas: las tres dimensiones espaciales (

,

, ,

, ) y el tiempo (

) y el tiempo ( ).

El nuevo esquema de Minkowski obligó a reinterpretar los conceptos de

la métrica existentes hasta entonces. El concepto tridimensional de punto fue sustituido por el de evento. La magnitud de distancia se reemplaza por la magnitud de intervalo.

).

El nuevo esquema de Minkowski obligó a reinterpretar los conceptos de

la métrica existentes hasta entonces. El concepto tridimensional de punto fue sustituido por el de evento. La magnitud de distancia se reemplaza por la magnitud de intervalo.Relatividad general

Debe notarse que el matemático alemán David Hilbert escribió e hizo públicas las ecuaciones de la covarianza antes que Einstein. Ello resultó en no pocas acusaciones de plagio contra Einstein, pero probablemente sea más, porque es una teoría (o perspectiva) geométrica. La misma postula que la presencia de masa o energía «curva» al espacio-tiempo, y esta curvatura afecta la trayectoria de los cuerpos móviles e incluso la trayectoria de la luz.

Einstein expresó el propósito de la teoría de la relatividad general para aplicar plenamente el programa de Ernst Mach de la relativización de todos los efectos de inercia, incluso añadiendo la llamada constante cosmológica a sus ecuaciones de campo4 para este propósito. Este punto de contacto real de la influencia de Ernst Mach fue claramente identificado en 1918, cuando Einstein distingue lo que él bautizó como el principio de Mach (los efectos inerciales se derivan de la interacción de los cuerpos) del principio de la relatividad general, que se interpreta ahora como el principio de covarianza general.5

Formalismo de la teoría de la relatividad

Véanse también: Espacio-tiempo, Cuadrivector y Tensor.

Partículas

En la teoría de la relatividad una partícula puntual queda representada por un par , donde

, donde  es una curva diferenciable, llamada línea de universo de la partícula, y m es un escalar que representa la masa en reposo. El vector tangente a esta curva es un vector temporal llamado cuadrivelocidad, el producto de este vector por la masa en reposo de la partícula es precisamente el cuadrimomento.

Este cuadrimomento es un vector de cuatro componentes, tres de estas

componentes se denominan espaciales y representan el análogo relativista

del momento lineal de la mecánica clásica, la otra componente denominada componente temporal representa la generalización relativista de la energía cinética. Además, dada una curva arbitraria en el espacio-tiempo, puede definirse a lo largo de ella el llamado intervalo relativista, que se obtiene a partir del tensor métrico. El intervalo relativista medido a lo largo de la trayectoria de una partícula es proporcional al intervalo de tiempo propio o intervalo de tiempo percibido por dicha partícula.

es una curva diferenciable, llamada línea de universo de la partícula, y m es un escalar que representa la masa en reposo. El vector tangente a esta curva es un vector temporal llamado cuadrivelocidad, el producto de este vector por la masa en reposo de la partícula es precisamente el cuadrimomento.

Este cuadrimomento es un vector de cuatro componentes, tres de estas

componentes se denominan espaciales y representan el análogo relativista

del momento lineal de la mecánica clásica, la otra componente denominada componente temporal representa la generalización relativista de la energía cinética. Además, dada una curva arbitraria en el espacio-tiempo, puede definirse a lo largo de ella el llamado intervalo relativista, que se obtiene a partir del tensor métrico. El intervalo relativista medido a lo largo de la trayectoria de una partícula es proporcional al intervalo de tiempo propio o intervalo de tiempo percibido por dicha partícula.Campos

Cuando se consideran campos o distribuciones continuas de masa se necesita algún tipo de generalización para la noción de partícula. Un campo físico posee momentum y energía distribuidos en el espacio-tiempo, el concepto de cuadrimomento se generaliza mediante el llamado tensor de energía-impulso que representa la distribución en el espacio-tiempo tanto de energía como de momento lineal. A su vez un campo dependiendo de su naturaleza puede representarse por un escalar, un vector o un tensor. Por ejemplo el campo electromagnético se representa por un tensor de segundo orden totalmente antisimétrico o 2-forma. Si se conoce la variación de un campo o una distribución de materia, en el espacio y en el tiempo entonces existen procedimientos para construir su tensor de energía-impulso.Magnitudes físicas

En relatividad, estas magnitudes físicas son representadas por vectores 4-dimensionales o bien por objetos matemáticos llamados tensores, que generalizan los vectores, definidos sobre un espacio de cuatro dimensiones. Matemáticamente estos 4-vectores y 4-tensores son elementos definidos del espacio vectorial tangente al espacio-tiempo (y los tensores se definen y se construyen a partir del fibrado tangente o cotangente de la variedad que representa el espacio-tiempo).| Espacio tridimensional euclídeo | Espacio-tiempo de Minkowski |

|---|---|

| Punto | Evento |

| Longitud | Intervalo |

| Velocidad | Cuadrivelocidad |

| Momentum | Cuadriamomentum |

El intervalo relativista

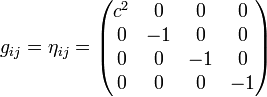

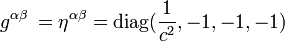

El intervalo relativista puede definirse en cualquier espacio-tiempo, sea éste plano como en la relatividad especial, o curvo como en relatividad general. Sin embargo, por simplicidad, discutiremos inicialmente el concepto de intervalo para el caso de un espacio-tiempo plano. El tensor métrico del espacio-tiempo plano de Minkowski se designa con la letra , y en coordenadas galileanas o inerciales toma la siguiente forma:nota 4

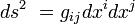

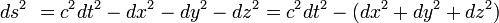

, y en coordenadas galileanas o inerciales toma la siguiente forma:nota 4El intervalo, la distancia tetradimensional, se representa mediante la expresión

, que se calcula del siguiente modo:

, que se calcula del siguiente modo:

es negativo), temporales (si

es negativo), temporales (si  es positivo) y nulos (cuando

es positivo) y nulos (cuando  ).

Como el lector habrá podido comprobar, los intervalos nulos son

aquellos que corresponden a partículas que se mueven a la velocidad de

la luz, como los fotones: La distancia

).

Como el lector habrá podido comprobar, los intervalos nulos son

aquellos que corresponden a partículas que se mueven a la velocidad de

la luz, como los fotones: La distancia  recorrida por el fotón es igual a su velocidad (c) multiplicada por el tiempo

recorrida por el fotón es igual a su velocidad (c) multiplicada por el tiempo  y por lo tanto el intervalo

y por lo tanto el intervalo  se hace nulo.

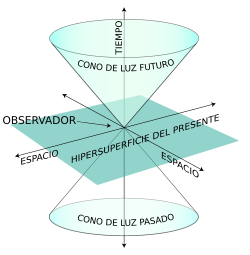

se hace nulo.Los intervalos nulos pueden ser representados en forma de cono de luz, popularizados por el celebérrimo libro de Stephen Hawking, Historia del Tiempo. Sea un observador situado en el origen, el futuro absoluto (los sucesos que serán percibidos por el individuo) se despliega en la parte superior del eje de ordenadas, el pasado absoluto (los sucesos que ya han sido percibidos por el individuo) en la parte inferior, y el presente percibido por el observador en el punto 0. Los sucesos que están fuera del cono de luz no nos afectan, y por lo tanto se dice de ellos que están situados en zonas del espacio-tiempo que no tienen relación de causalidad con la nuestra.

Imaginemos, por un momento, que en la galaxia Andrómeda, situada a 2,5 millones de años luz de nosotros, sucedió un cataclismo cósmico hace 100.000 años. Dado que, primero: la luz de Andrómeda tarda 2 millones de años en llegar hasta nosotros y segundo: nada puede viajar a una velocidad superior a la de los fotones, es evidente, que no tenemos manera de enterarnos de lo que sucedió en dicha Galaxia hace tan sólo 100.000 años. Se dice por lo tanto que el intervalo existente entre dicha hipotética catástrofe cósmica y nosotros, observadores del presente, es un intervalo espacial (

),

y por lo tanto, no puede afectar a los individuos que en el presente

viven en la Tierra: Es decir, no existe relación de causalidad entre ese

evento y nosotros.

),

y por lo tanto, no puede afectar a los individuos que en el presente

viven en la Tierra: Es decir, no existe relación de causalidad entre ese

evento y nosotros.

- Análisis

Podemos escoger otro episodio histórico todavía más ilustrativo: El de la estrella de Belén, tal y como fue interpretada por Johannes Kepler. Este astrónomo alemán consideraba que dicha estrella se identificaba con una supernova que tuvo lugar el año 5 a. C., cuya luz fue observada por los astrónomos chinos contemporáneos, y que vino precedida en los años anteriores por varias conjunciones planetarias en la constelación de Piscis. Esa supernova probablemente estalló hace miles de años atrás, pero su luz no llegó a la tierra hasta el año 5 a. C. De ahí que el intervalo existente entre dicho evento y las observaciones de los astrónomos egipcios y megalíticos (que tuvieron lugar varios siglos antes de Cristo) sea un intervalo espacial, pues la radiación de la supernova nunca pudo llegarles. Por el contrario, la explosión de la supernova por un lado, y las observaciones realizadas por los tres magos en Babilonia y por los astrónomos chinos en el año 5 a. C. por el otro, están unidas entre sí por un intervalo temporal, ya que la luz sí pudo alcanzar a dichos observadores.

El tiempo propio y el intervalo se relacionan mediante la siguiente equivalencia:

,

es decir, el intervalo es igual al tiempo local multiplicado por la

velocidad de la luz. Una de las características tanto del tiempo local

como del intervalo es su invarianza ante las transformaciones de

coordenadas. Sea cual sea nuestro punto de referencia, sea cual sea

nuestra velocidad, el intervalo entre un determinado evento y nosotros

permanece invariante.

,

es decir, el intervalo es igual al tiempo local multiplicado por la

velocidad de la luz. Una de las características tanto del tiempo local

como del intervalo es su invarianza ante las transformaciones de

coordenadas. Sea cual sea nuestro punto de referencia, sea cual sea

nuestra velocidad, el intervalo entre un determinado evento y nosotros

permanece invariante.Esta invarianza se expresa a través de la llamada geometría hiperbólica: La ecuación del intervalo

tiene la estructura de una hipérbola sobre cuatro dimensiones, cuyo término independiente coincide con el valor del cuadrado del intervalo (

tiene la estructura de una hipérbola sobre cuatro dimensiones, cuyo término independiente coincide con el valor del cuadrado del intervalo ( ), que como se acaba de decir en el párrafo anterior, es constante. Las asíntotas de la hipérbola vendrían a coincidir con el cono de luz.

), que como se acaba de decir en el párrafo anterior, es constante. Las asíntotas de la hipérbola vendrían a coincidir con el cono de luz.Cuadrivelocidad, aceleración y cuadrimomentum

En el espacio-tiempo de Minkowski, las propiedades cinemáticas de las partículas se representan fundamentalmente por tres magnitudes: La cuadrivelocidad (o tetravelocidad) , la cuadriaceleración y el cuadrimomentum (o tetramomentum).La cuadrivelocidad es un cuadrivector tangente a la línea de universo de la partícula, relacionada con la velocidad coordenada de un cuerpo medida por un observador en reposo cualquiera, esta velocidad coordenada se define con la expresión newtoniana

, donde

, donde  son el tiempo coordenado y las coordenadas espaciales medidas por el observador, para el cual la velocidad newtoniana ampliada vendría dada por

son el tiempo coordenado y las coordenadas espaciales medidas por el observador, para el cual la velocidad newtoniana ampliada vendría dada por  .

Sin embargo, esta medida newtoniana de la velocidad no resulta útil en

teoría de la relatividad, porque las velocidades newtonianas medidas por

diferentes observadores no son fácilmente relacionables por no ser

magnitudes covariantes. Así en relatividad se introduce una modificación

en las expresiones que dan cuenta de la velocidad, introduciendo un invariante relativista. Este invariante es precisamente el tiempo propio

de la partícula que es fácilmente relacionable con el tiempo coordenado

de diferentes observadores. Usando la relación entre tiempo propio y

tiempo coordenado:

.

Sin embargo, esta medida newtoniana de la velocidad no resulta útil en

teoría de la relatividad, porque las velocidades newtonianas medidas por

diferentes observadores no son fácilmente relacionables por no ser

magnitudes covariantes. Así en relatividad se introduce una modificación

en las expresiones que dan cuenta de la velocidad, introduciendo un invariante relativista. Este invariante es precisamente el tiempo propio

de la partícula que es fácilmente relacionable con el tiempo coordenado

de diferentes observadores. Usando la relación entre tiempo propio y

tiempo coordenado:  se define la cuadrivelocidad [propia] multiplicando por

se define la cuadrivelocidad [propia] multiplicando por  las de la velocidad coordenada:

las de la velocidad coordenada:  .

.La velocidad coordenada de un cuerpo con masa depende caprichosamente del sistema de referencia que escojamos, mientras que la cuadrivelocidad propia es una magnitud que se transforma de acuerdo con el principio de covariancia y tiene un valor siempre constante equivalente al intervalo dividido entre el tiempo propio (

), o lo que es lo mismo, a la velocidad de la luz c.

Para partículas sin masa, como los fotones, el procedimiento anterior

no se puede aplicar, y la cuadrivelocidad puede definirse simplemente

como vector tangente a la trayectoria seguida por los mismos.

), o lo que es lo mismo, a la velocidad de la luz c.

Para partículas sin masa, como los fotones, el procedimiento anterior

no se puede aplicar, y la cuadrivelocidad puede definirse simplemente

como vector tangente a la trayectoria seguida por los mismos.La cuadriaceleración puede ser definida como la derivada temporal de la cuadrivelocidad (

).

Su magnitud es igual a cero en los sistemas inerciales, cuyas líneas

del mundo son geodésicas, rectas en el espacio-tiempo llano de

Minkowski. Por el contrario, las líneas del mundo curvadas corresponden a

partículas con aceleración diferente de cero, a sistemas no inerciales.

).

Su magnitud es igual a cero en los sistemas inerciales, cuyas líneas

del mundo son geodésicas, rectas en el espacio-tiempo llano de

Minkowski. Por el contrario, las líneas del mundo curvadas corresponden a

partículas con aceleración diferente de cero, a sistemas no inerciales.Junto con los principios de invarianza del intervalo y la cuadrivelocidad, juega un papel fundamental la ley de conservación del cuadrimomentum. Es aplicable aquí la definición newtoniana del momentum (

) como la masa (en este caso conservada,

) como la masa (en este caso conservada,  ) multiplicada por la velocidad (en este caso, la cuadrivelocidad), y por lo tanto sus componentes son los siguientes:

) multiplicada por la velocidad (en este caso, la cuadrivelocidad), y por lo tanto sus componentes son los siguientes:  , teniendo en cuenta que

, teniendo en cuenta que  . La cantidad de momentum conservado

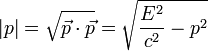

es definida como la raíz cuadrada de la norma del vector de

cuadrimomentum. El momentum conservado, al igual que el intervalo y la

cuadrivelocidad propia, permanece invariante ante las transformaciones de coordenadas, aunque también aquí hay que distinguir entre los cuerpos con masa y los fotones. En los primeros, la magnitud del cuadriomentum es igual a la masa multiplicada por la velocidad de la luz (

. La cantidad de momentum conservado

es definida como la raíz cuadrada de la norma del vector de

cuadrimomentum. El momentum conservado, al igual que el intervalo y la

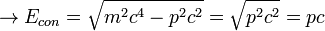

cuadrivelocidad propia, permanece invariante ante las transformaciones de coordenadas, aunque también aquí hay que distinguir entre los cuerpos con masa y los fotones. En los primeros, la magnitud del cuadriomentum es igual a la masa multiplicada por la velocidad de la luz ( ). Por el contrario, el cuadrimomentum conservado de los fotones es igual a la magnitud de su momentum tridimensional (

). Por el contrario, el cuadrimomentum conservado de los fotones es igual a la magnitud de su momentum tridimensional ( ).

).Como tanto la velocidad de la luz como el cuadrimomentum son magnitudes conservadas, también lo es su producto, al que se le da el nombre de energía conservada (

), que en los cuerpos con masa equivale a la masa multiplicada por la velocidad de la luz al cuadrado (

), que en los cuerpos con masa equivale a la masa multiplicada por la velocidad de la luz al cuadrado ( , la famosa fórmula de Einstein) y en los fotones al momentum multiplicado por la velocidad de la luz (

, la famosa fórmula de Einstein) y en los fotones al momentum multiplicado por la velocidad de la luz ( )

)Componentes

Magnitud del cuadrimomentum

Magnitud en cuerpos con masa

Magnitud en fotones (masa = 0)

Energía

Energía en cuerpos con masa (cuerpos en reposo, p=0)

Energía en fotones (masa en reposo = 0)

La aparición de la Relatividad Especial puso fin a la secular disputa que mantenían en el seno de la mecánica clásica las escuelas de los mecanicistas y los energetistas. Los primeros sostenían, siguiendo a Descartes y Huygens, que la magnitud conservada en todo movimiento venía constituida por el momentum total del sistema, mientras que los energetistas -que tomaban por base los estudios de Leibniz- consideraban que la magnitud conservada venía conformada por la suma de dos cantidades: La fuerza viva, equivalente a la mitad de la masa multiplicada por la velocidad al cuadrado (

) a la que hoy denominaríamos "energía cinética", y la fuerza muerta, equivalente a la altura por la constante g (

) a la que hoy denominaríamos "energía cinética", y la fuerza muerta, equivalente a la altura por la constante g ( ), que correspondería a la "energía potencial". Fue el físico alemán Hermann von Helmholtz el que primero dio a la fuerzas leibnizianas la denominación genérica de energía y el que formuló la Ley de conservación de la energía, que no se restringe a la mecánica, que se extiende también a otras disciplinas físicas como la termodinámica.

), que correspondería a la "energía potencial". Fue el físico alemán Hermann von Helmholtz el que primero dio a la fuerzas leibnizianas la denominación genérica de energía y el que formuló la Ley de conservación de la energía, que no se restringe a la mecánica, que se extiende también a otras disciplinas físicas como la termodinámica.La mecánica newtoniana dio la razón a ambos postulados, afirmando que tanto el momentum como la energía son magnitudes conservadas en todo movimiento sometido a fuerzas conservativas. Sin embargo, la Relatividad Especial dio un paso más allá, por cuanto a partir de los trabajos de Einstein y Minkowski el momentum y la energía dejaron de ser considerados como entidades independientes y se les pasó a considerar como dos aspectos, dos facetas de una única magnitud conservada: el cuadrimomentum.

| Concepto | Componentes | Expresión algebraica | Partículas con masa | Fotones |

|---|---|---|---|---|

| Intervalo |  |

|

|

|

| Cuadrivelocidad |  |

|

|

Cuadrivelocidad no definida |

| Aceleración |  |  (sistemas inerciales)  (sistemas no inerciales) | Aceleración no definida | |

| Cuadrimomentum |  |

|

|

|

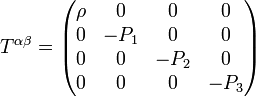

El tensor de energía-impulso (Tab)

) en un determinado punto es igual a la masa multiplicada por la constante G y dividida por la distancia r (2); y la tercera, finalmente, es la llamada ecuación de Poisson (3), que indica que el laplacianonota 5 del potencial gravitatorio es igual a

) en un determinado punto es igual a la masa multiplicada por la constante G y dividida por la distancia r (2); y la tercera, finalmente, es la llamada ecuación de Poisson (3), que indica que el laplacianonota 5 del potencial gravitatorio es igual a  , donde

, donde  es la densidad de masa en una determinada región esférica.

es la densidad de masa en una determinada región esférica.

Sin embargo, estas ecuaciones no son compatibles con la Relatividad Especial por dos razones:

- En primer lugar la masa no es una magnitud absoluta, sino que

su medición deriva en resultados diferentes dependiendo de la velocidad

relativa del observador. De ahí que la densidad de masa

no puede servir de parámetro de interacción gravitatoria entre dos cuerpos.

no puede servir de parámetro de interacción gravitatoria entre dos cuerpos. - En segundo lugar, si el concepto de espacio es relativo, también lo es la noción de densidad. Es evidente que la contracción del espacio producida por el incremento de la velocidad de un observador, impide la existencia de densidades que permanezcan invariables ante las transformaciones de Lorentz.

,

situado en el lado derecho de la fórmula de Poisson y sustituirlo por

un objeto geométrico-matemático que permanezca invariante ante las

transformaciones de Lorentz: Dicho objeto fue definido por Einstein en sus ecuaciones de universo y recibe el nombre de tensor de energía-momentum (

,

situado en el lado derecho de la fórmula de Poisson y sustituirlo por

un objeto geométrico-matemático que permanezca invariante ante las

transformaciones de Lorentz: Dicho objeto fue definido por Einstein en sus ecuaciones de universo y recibe el nombre de tensor de energía-momentum ( ). Sus coeficientes describen la cantidad de tetramomentum

). Sus coeficientes describen la cantidad de tetramomentum  que atraviesa una hipersuperficie

que atraviesa una hipersuperficie  , normal al vector unitario

, normal al vector unitario  .

.De este modo, el tensor de energía momentum puede expresarse mediante la siguiente ecuación:

O lo que es lo mismo: El componente

del tetramomentum es igual a la integral de hipersuperficie

del tetramomentum es igual a la integral de hipersuperficie  del tensor de tensión-energía.

del tensor de tensión-energía.En un fluido ideal, del que están ausentes tanto la viscosidad como la conducción de calor, los componentes del tetramomentum se calculan de la siguiente forma:

,

,

es la densidad de masa-energía (masa por unidad de volumen tridimensional),

es la densidad de masa-energía (masa por unidad de volumen tridimensional),  es la presión hidrostática,

es la presión hidrostática,  es la cuadrivelocidad del fluido, y

es la cuadrivelocidad del fluido, y  es la matriz inversa del tensor métrico de la variedad.

es la matriz inversa del tensor métrico de la variedad.Además, si los componentes del tensor se miden por un observador en reposo relativo respecto al fluido, entonces, el tensor métrico viene constituido simplemente por la métrica de Minkowski:

.

.

es la densidad de masa, y

es la densidad de masa, y  son los componentes tridimensionales de la presión hidrostática.

Como vemos, el campo gravitatorio tiene dos fuentes diferentes: La masa

y el momentum del fluido en cuestión. Los efectos gravitatorios

originados por la masa se denominan efectos gravitoeléctricos, mientras que aquellos que se deben al momentum reciben el nombre de efectos gravitomagnéticos. Los primeros tienen una intensidad

son los componentes tridimensionales de la presión hidrostática.

Como vemos, el campo gravitatorio tiene dos fuentes diferentes: La masa

y el momentum del fluido en cuestión. Los efectos gravitatorios

originados por la masa se denominan efectos gravitoeléctricos, mientras que aquellos que se deben al momentum reciben el nombre de efectos gravitomagnéticos. Los primeros tienen una intensidad  superior a los segundos, que sólo se manifiestan en aquellos casos en

los que las partículas del fluido se mueven con una velocidad cercana a

la de la luz (se habla entonces de fluidos relativistas): Es el caso de los chorros (jets)

que emanan del centro de la galaxia y que se propulsan en las dos

direcciones marcadas por el eje de rotación de este cuerpo cósmico; de

la materia que se precipita hacia un agujero negro; y del fluido estelar

que se dirige hacia el centro de la estrella cuando se ésta entra en

colapso. En este último caso, durante las fases finales del proceso de

contracción de la estrella, la presión hidrostática puede llegar a ser

tan fuerte como para llegar a acelerar el colapso, en lugar de

ralentizarlo.

superior a los segundos, que sólo se manifiestan en aquellos casos en

los que las partículas del fluido se mueven con una velocidad cercana a

la de la luz (se habla entonces de fluidos relativistas): Es el caso de los chorros (jets)

que emanan del centro de la galaxia y que se propulsan en las dos

direcciones marcadas por el eje de rotación de este cuerpo cósmico; de

la materia que se precipita hacia un agujero negro; y del fluido estelar

que se dirige hacia el centro de la estrella cuando se ésta entra en

colapso. En este último caso, durante las fases finales del proceso de

contracción de la estrella, la presión hidrostática puede llegar a ser

tan fuerte como para llegar a acelerar el colapso, en lugar de

ralentizarlo.Podemos, a partir del tensor de tensión-energía, calcular cuánta masa contiene un determinado volumen del fluido: Retomando la definición de este tensor expuesta unas líneas más arriba, se puede definir al coeficiente

como la cantidad de momentum

como la cantidad de momentum  (esto es, la masa) que atraviesa la hipersuperficie

(esto es, la masa) que atraviesa la hipersuperficie  . En el espacio-tiempo de Minkowski, la hipersuperficie

. En el espacio-tiempo de Minkowski, la hipersuperficie  es aquella región que se define por las tres bases vectoriales normales al vector

es aquella región que se define por las tres bases vectoriales normales al vector  :

:  es, por tanto, un volumen tridimensional, definido por los vectores base

es, por tanto, un volumen tridimensional, definido por los vectores base  (eje x),

(eje x),  (eje y), y

(eje y), y  (eje z). Podemos por tanto escribir:

(eje z). Podemos por tanto escribir: es aquella región del espacio-tiempo definida por los tres vectores unitarios normales a

es aquella región del espacio-tiempo definida por los tres vectores unitarios normales a  (se trata de los dos vectores espaciales,

(se trata de los dos vectores espaciales,  y

y  , correspondientes a los ejes y y z; y del vector temporal

, correspondientes a los ejes y y z; y del vector temporal  —o

—o  ,

como se prefiera—). Esta definición nos permite descomponer la integral

de hipersuperficie en una integral temporal (cuyo integrando viene

definido por

,

como se prefiera—). Esta definición nos permite descomponer la integral

de hipersuperficie en una integral temporal (cuyo integrando viene

definido por  ) y otra de superficie (esta vez bidimensional,

) y otra de superficie (esta vez bidimensional,  ):

):El tensor electromagnético (Fab)

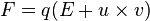

Las ecuaciones deducidas por el físico escocés James Clerk Maxwell demostraron que electricidad y magnetismo no son más que dos manifestaciones de un mismo fenómeno físico: el campo electromagnético. Ahora bien, para describir las propiedades de este campo los físicos de finales del siglo XIX debían utilizar dos vectores diferentes, los correspondientes los campos eléctrico y magnético.Fue la llegada de la Relatividad Especial la que permitió describir las propiedades del electromagnetismo con un sólo objeto geométrico, el vector cuadripotencial, cuyo componente temporal se correspondía con el potencial eléctrico, mientras que sus componentes espaciales eran los mismos que los del potencial magnético.

La fuerza de Lorentz puede deducirse a partir de la siguiente expresión:

la cuadrivelocidad de la partícula.

la cuadrivelocidad de la partícula.PREDESIBILIDAD:

Predicción tiene por etimología el latín pre+dicere,

esto es, “decir antes”. Una vez sabido el significado general, conviene

irlo afinando para ajustarlo a los usos que la práctica demanda. Por

ello, no se trata sólo de “decir antes”, sino de “decirlo bien”, o sea,

acertar; también, hacerlo con un plazo suficiente para poder tomar las

medidas que se crean oportunas, y además tener una idea de hasta cuándo

es posible predecir el futuro con cierto éxito.

Cuando

se efectúa una predicción, se está estimando un valor futuro de alguna

variable que se considere representativa de una cierta situación. Por

ejemplo, en cuestiones climáticas podría tratarse de temperaturas medias

de la atmósfera en determinados niveles, concentraciones de gases,

precipitación, etc. También se pueden hacer predicciones espaciales,

como la ubicación, movilidad e intensidad local de fenómenos extremos,

caso por ejemplo de los huracanes y tormentas tropicales. Normalmente

ambos tipos de predicción están ligados y se realizan a la vez, como lo

prueban los productos que ofrecen las grandes agencias e institutos de

Meteorología y Climatología.

Las estimaciones realizadas para predecir se denominan predictores.

Pueden construirse de modos muy diversos, de algunos de los cuales nos

ocuparemos en este trabajo, y su bondad se mide -como es natural- por el

porcentaje de aciertos en situaciones del pasado predichas con igual

técnica. Las bases de registros disponibles hoy día permiten realizar

experimentos de predecibilidad con datos pasados y simular situaciones

ya conocidas mediante diversas técnicas, estudiando y comparando los

resultados. Es claro que para estos experimentos la tercera propiedad de

la predicción no tiene demasiado interés, pues la predicción -o mejor,

simulación- del pasado no incita a la prisa.

Sin

embargo, en las predicciones día a día para fenómenos meteorológicos, o

anualmente para situaciones climáticas, es conveniente que la

predicción pueda llevarse a cabo con antelación suficiente. Por

supuesto, hay predictores que se pueden formular de inmediato: por

ejemplo tomemos la permanencia y el paseo aleatorio. El

primero consiste en suponer que la situación actual se prolongará hasta

el momento para el que se quiere predecir; el segundo supone que la

predicción es una mera cuestión de suerte. Ambos son predictores válidos

y utilizados con frecuencia como “enemigos a batir” por cualquier otro

diseño de predicción. Pero no todos los métodos son tan rápidos, y lleva

siempre cierto tiempo efectuar la predicción.

CAOS:

La

teoría de las estructuras disipativas, conocida también como teoría del

caos, tiene como principal representante al químico belga Ilya

Prigogine, y plantea que el mundo no sigue estrictamente el modelo del

reloj, previsible y determinado, sino que tiene aspectos caóticos. El

observador no es quien crea la inestabilidad o la imprevisibilidad con

su ignorancia: ellas existen de por sí, y un ejemplo típico el clima.

Efecto

mariposa y caos matemático.- Empezaremos con la parte anecdótica de la

teoría del caos, el famoso "efecto mariposa" Es decir, comenzaremos a

investigar el iceberg a partir de su punta visible que, como sabemos, es

apenas una mínima fracción del total.

En principio, las relaciones entre causas y efectos pueden examinarse desde dos puntos de vista: cualitativo y cuantitativo.

En principio, las relaciones entre causas y efectos pueden examinarse desde dos puntos de vista: cualitativo y cuantitativo.

La

teoría del caos, en la medida en que considera que existen procesos

aleatorios, adopta la postura (b), pero en la medida en que dice que

ciertos otros procesos no son caóticos sino ordenados, sostiene que sí,

que existen vínculos causales. Los vínculos causales que más

desarrollará son los circuitos de retroalimentación positiva, es decir,

aquellos donde se verifica una amplificación de las desviaciones: por

ejemplo, una pequeña causa inicial, mediante un proceso amplificador,

podrá generar un efecto considerablemente grande.

RADIOACTIVIDAD:

La radiactividad o radioactividad1 es un fenómeno físico por el cual los núcleos de algunos elementos químicos, llamados radiactivos, emiten radiaciones que tienen la propiedad de impresionar placas radiográficas, ionizar gases, producir fluorescencia, atravesar cuerpos opacos a la luz ordinaria, entre otros. Debido a esa capacidad, se les suele denominar radiaciones ionizantes (en contraste con las no ionizantes). Las radiaciones emitidas pueden ser electromagnéticas, en forma de rayos X o rayos gamma, o bien corpusculares, como pueden ser núcleos de helio, electrones o positrones, protones u otras. En resumen, es un fenómeno que ocurre en los núcleos de ciertos elementos, inestables, que son capaces de transformarse, o decaer, espontáneamente, en núcleos atómicos de otros elementos más estables.

La radiactividad ioniza el medio que atraviesa. Una excepción lo constituye el neutrón, que posee carga neutra (igual carga positiva como negativa), pero ioniza la materia en forma indirecta. En las desintegraciones radiactivas se tienen varios tipos de radiación: alfa, beta, gamma y neutrones.

La radiactividad es una propiedad de los isótopos que son "inestables", es decir, que se mantienen en un estado excitado en sus capas electrónicas o nucleares, con lo que, para alcanzar su estado fundamental, deben perder energía. Lo hacen en emisiones electromagnéticas o en emisiones de partículas con una determinada energía cinética. Esto se produce variando la energía de sus electrones (emitiendo rayos X) o de sus nucleones (rayo gamma) o variando el isótopo (al emitir desde el núcleo electrones, positrones, neutrones, protones o partículas más pesadas), y en varios pasos sucesivos, con lo que un isótopo pesado puede terminar convirtiéndose en uno mucho más ligero, como el uranio que, con el transcurrir de los siglos, acaba convirtiéndose en plomo.

La radiactividad se aprovecha para la obtención de energía nuclear, se usa en medicina (radioterapia y radiodiagnóstico) y en aplicaciones industriales (medidas de espesores y densidades, entre otras).

La radiactividad puede ser:

- Natural: manifestada por los isótopos que se encuentran en la naturaleza.

- Artificial o inducida: manifestada por los radioisótopos producidos en transformaciones artificiales.

Radiactividad natural

Véanse también: Radiactividad natural, Rayos cósmicos y Redradna.

En 1896 Henri Becquerel

descubrió que ciertas sales de uranio emiten radiaciones

espontáneamente, al observar que velaban las placas fotográficas

envueltas en papel negro. Hizo ensayos con el mineral en caliente, en

frío, pulverizado, disuelto en ácidos y la intensidad de la misteriosa

radiación era siempre la misma. Por tanto, esta nueva propiedad de la

materia, que recibió el nombre de radiactividad, no dependía de la forma

física o química en la que se encontraban los átomos del cuerpo

radiactivo, sino que era una propiedad que radicaba en el interior mismo

del átomo.El estudio del nuevo fenómeno y su desarrollo posterior se debe casi exclusivamente al matrimonio de Marie y Pierre Curie, quienes encontraron otras sustancias radiactivas: el torio, el polonio y el radio. La intensidad de la radiación emitida era proporcional a la cantidad de uranio presente, por lo que Marie Curie dedujo que la radiactividad es una propiedad atómica. El fenómeno de la radiactividad se origina exclusivamente en el núcleo de los átomos radiactivos. Se cree que se origina debido a la interacción neutrón-protón. Al estudiar la radiación emitida por el radio, se comprobó que era compleja, pues al aplicarle un campo magnético parte de ella se desviaba de su trayectoria y otra parte no.

Pronto se vio que todas estas reacciones provienen del núcleo atómico que describió Ernest Rutherford en 1911, quien también demostró que las radiaciones emitidas por las sales de uranio pueden ionizar el aire y producir la descarga de cuerpos cargados eléctricamente.

Con el uso del neutrón, partícula teorizada en 1920 por Ernest Rutherford, se consiguió describir la radiación beta.

En 1932, James Chadwick descubrió la existencia del neutrón que Rutherford había predicho en 1920, e inmediatamente después Enrico Fermi descubrió que ciertas radiaciones emitidas en fenómenos no muy comunes de desintegración son en realidad neutrones.

Radiactividad artificial

Nuevo símbolo de advertencia de radiactividad adoptado por la ISO en 2007 para fuentes que puedan resultar peligrosas. Estándar ISO #21482.

En 1934 Fermi se encontraba en un experimento bombardeando núcleos de uranio con los neutrones recién descubiertos. En 1938, en Alemania, Lise Meitner, Otto Hahn y Fritz Strassmann verificaron los experimentos de Fermi. En 1939 demostraron que una parte de los productos que aparecían al llevar a cabo estos experimentos era bario. Muy pronto confirmaron que era resultado de la división de los núcleos de uranio: la primera observación experimental de la fisión. En Francia, Jean Frédéric Joliot-Curie descubrió que, además del bario, se emiten neutrones secundarios en esa reacción, lo que hace factible la reacción en cadena.

También en 1932, Mark Oliphant teorizó sobre la fusión de núcleos ligeros (de hidrógeno), y poco después Hans Bethe describió el funcionamiento de las estrellas con base en este mecanismo.

El estudio de la radiactividad permitió un mayor conocimiento de la estructura del núcleo atómico y de las partículas subatómicas. Se abrió la posibilidad de convertir unos elementos en otros. Incluso se hizo realidad el ancestral sueño de los alquimistas de crear oro a partir de otros elementos, como por ejemplo átomos de mercurio, aunque en términos prácticos el proceso de convertir mercurio en oro no resulta rentable debido a que el proceso requiere demasiada energía.

El 15 de marzo de 1994, la Agencia Internacional de la Energía Atómica (AIEA) dio a conocer un nuevo símbolo de advertencia de radiactividad con validez internacional. La imagen fue probada en 11 países.

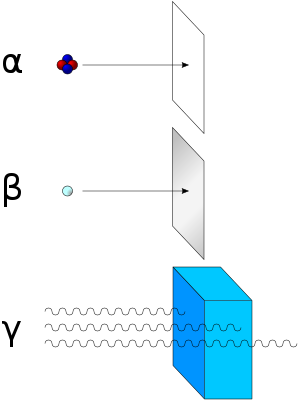

Clases y componentes de la radiación

Clases de radiación ionizante y cómo detenerla.

Las partículas alfa (núcleos de helio) se detienen al interponer una hoja de papel. Las partículas beta (electrones y positrones) no pueden atravesar una capa de aluminio. Sin embargo, los rayos gamma (fotones de alta energía) necesitan una barrera mucho más gruesa, y los más energéticos pueden atravesar el plomo.

Las partículas alfa (núcleos de helio) se detienen al interponer una hoja de papel. Las partículas beta (electrones y positrones) no pueden atravesar una capa de aluminio. Sin embargo, los rayos gamma (fotones de alta energía) necesitan una barrera mucho más gruesa, y los más energéticos pueden atravesar el plomo.

- Partícula alfa: Son flujos de partículas cargadas positivamente compuestas por dos neutrones y dos protones (núcleos de helio). Son desviadas por campos eléctricos y magnéticos. Son poco penetrantes, aunque muy ionizantes. Son muy energéticas. Fueron descubiertas por Rutherford, quien hizo pasar partículas alfa a través de un fino cristal y las atrapó en un tubo de descarga. Este tipo de radiación la emiten núcleos de elementos pesados situados al final de la tabla periódica (A >100). Estos núcleos tienen muchos protones y la repulsión eléctrica es muy fuerte, por lo que tienden a obtener N aproximadamente igual a Z, y para ello se emite una partícula alfa. En el proceso se desprende mucha energía, que se convierte en la energía cinética de la partícula alfa, por lo que estas partículas salen con velocidades muy altas.

- Desintegración beta: Son flujos de electrones (beta negativas) o positrones (beta positivas) resultantes de la desintegración de los neutrones o protones del núcleo cuando éste se encuentra en un estado excitado. Es desviada por campos magnéticos. Es más penetrante, aunque su poder de ionización no es tan elevado como el de las partículas alfa. Por lo tanto, cuando un átomo expulsa una partícula beta, su número atómico aumenta o disminuye una unidad (debido al protón ganado o perdido). Existen tres tipos de radiación beta: la radiación beta-, que consiste en la emisión espontánea de electrones por parte de los núcleos; la radiación beta+, en la que un protón del núcleo se desintegra y da lugar a un neutrón, a un positrón o partícula Beta+ y un neutrino, y por último la captura electrónica que se da en núcleos con exceso de protones, en la cual el núcleo captura un electrón de la corteza electrónica, que se unirá a un protón del núcleo para dar un neutrón.

- Radiación gamma: Se trata de ondas electromagnéticas. Es el tipo más penetrante de radiación. Al ser ondas electromagnéticas de longitud de onda corta, tienen mayor penetración y se necesitan capas muy gruesas de plomo u hormigón para detenerlas. En este tipo de radiación el núcleo no pierde su identidad, sino que se desprende de la energía que le sobra para pasar a otro estado de energía más baja emitiendo los rayos gamma, o sea fotones muy energéticos. Este tipo de emisión acompaña a las radiaciones alfa y beta. Por ser tan penetrante y tan energética, éste es el tipo más peligroso de radiación.

- Cuando un átomo radiactivo emite una partícula alfa, la masa del átomo (A) resultante disminuye en 4 unidades y el número atómico (Z) en 2.

- Cuando un átomo radiactivo emite una partícula beta, el número atómico (Z) aumenta o disminuye en una unidad y la masa atómica (A) se mantiene constante.

- Cuando un núcleo excitado emite radiación gamma, no varía ni su masa ni su número atómico: sólo pierde una cantidad de energía hν (donde "h" es la constante de Planck y "ν" es la frecuencia de la radiación emitida).

Causa de la radiactividad

En general son radiactivas las sustancias que no presentan un balance correcto entre protones o neutrones, tal como muestra el gráfico que encabeza este artículo. Cuando el número de neutrones es excesivo o demasiado pequeño respecto al número de protones, se hace más difícil que la fuerza nuclear fuerte debida al efecto del intercambio de piones pueda mantenerlos unidos. Eventualmente, el desequilibrio se corrige mediante la liberación del exceso de neutrones o protones, en forma de partículas α que son realmente núcleos de helio, y partículas β, que pueden ser electrones o positrones. Estas emisiones llevan a dos tipos de radiactividad, ya mencionados:- Radiación α, que aligera los núcleos atómicos en 4 unidades másicas, y cambia el número atómico en dos unidades.

- Radiación β, que no cambia la masa del núcleo, ya que implica la conversión de un protón en un neutrón o viceversa, y cambia el número atómico en una sola unidad (positiva o negativa, según si la partícula emitida es un electrón o un positrón).

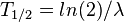

Período de semidesintegración radiactiva

La desintegración radiactiva se comporta en función de la ley de decaimiento exponencial:donde:

es el número de radionúclidos existentes en un instante de tiempo

es el número de radionúclidos existentes en un instante de tiempo  .

. es el número de radionúclidos existentes en el instante inicial

es el número de radionúclidos existentes en el instante inicial  .

. , llamada constante de desintegración radiactiva, es la probabilidad de desintegración por unidad de tiempo. A partir de la definición de actividad (ver Velocidad de desintegración),

es evidente que la constante de desintegración es el cociente entre el

número de desintegraciones por segundo y el número de átomos radiactivos

(

, llamada constante de desintegración radiactiva, es la probabilidad de desintegración por unidad de tiempo. A partir de la definición de actividad (ver Velocidad de desintegración),

es evidente que la constante de desintegración es el cociente entre el

número de desintegraciones por segundo y el número de átomos radiactivos

( ).

).

).

).Al tiempo que transcurre hasta que la cantidad de núcleos radiactivos de un isótopo radiactivo se reduzca a la mitad de la cantidad inicial se le conoce como periodo de semidesintegración, período, semiperiodo, semivida o vida media (no confundir con el ya mencionado tiempo de vida) (

).

Al final de cada período, la radiactividad se reduce a la mitad de la

radiactividad inicial. Cada radioisótopo tiene un semiperiodo

característico, en general diferente del de otros isótopos.

).

Al final de cada período, la radiactividad se reduce a la mitad de la

radiactividad inicial. Cada radioisótopo tiene un semiperiodo

característico, en general diferente del de otros isótopos.Ejemplos:

| Isótopo | Periodo | Emisión |

|---|---|---|

| Uranio-238 | 4510 millones de años | Alfa |

| Carbono-14 | 5730 años | Beta |

| Cobalto-60 | 5,271 años | Gamma |

| Radón-222 | 3,82 días | Alfa |

Velocidad de desintegración

La velocidad de desintegración o actividad radiactiva se mide en Bq, en el SI. Un becquerel vale 1 desintegración por segundo. También existen otras unidades: el rutherford, que equivale a 106 desintegraciones por segundo, o el curio, Ci, que equivale idénticamente a 3,7·1010 desintegraciones por segundo (unidad basada en la actividad de 1 g de 226Ra que es cercana a esa cantidad). Empíricamente se ha determinado que la velocidad de desintegración es la tasa de variación del número de núcleos radiactivos por unidad de tiempo:Dada la ley de desintegración radiactiva que sigue

(ver Periodo de semidesintegración), es evidente que:

(ver Periodo de semidesintegración), es evidente que:donde:,

es la actividad radiactiva en el instante

es la actividad radiactiva en el instante  .

. es la actividad radiactiva inicial (cuando

es la actividad radiactiva inicial (cuando  ).

). es la base de los logaritmos neperianos.

es la base de los logaritmos neperianos. es el tiempo transcurrido.

es el tiempo transcurrido. es la constante de desintegración radiactiva propia de cada radioisótopo.

es la constante de desintegración radiactiva propia de cada radioisótopo.

NUCLEO:

El núcleo atómico es la parte central de un átomo, tiene carga positiva, y concentra más del 99,9% de la masa total del átomo.

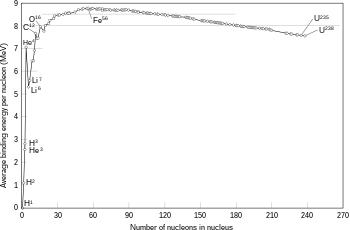

Está formado por protones y neutrones (denominados nucleones) que se mantienen unidos por medio de la interacción nuclear fuerte, la cual permite que el núcleo sea estable, a pesar de que los protones se repelen entre sí (como los polos iguales de dos imanes). La cantidad de protones en el núcleo (número atómico), determina el elemento químico al que pertenece. Los núcleos atómicos no necesariamente tienen el mismo número de neutrones, ya que átomos de un mismo elemento pueden tener masas diferentes, es decir son isótopos del elemento.

La existencia del núcleo atómico fue deducida del experimento de Rutherford, donde se bombardeó una lámina fina de oro con partículas alfa, que son núcleos atómicos de helio emitidos por rocas radiactivas. La mayoría de esas partículas traspasaban la lámina, pero algunas rebotaban, lo cual demostró la existencia de un minúsculo núcleo atómico.

Historia

El descubrimiento de los electrones fue la primera indicación de la estructura interna de los átomos. A comienzos del siglo XX el modelo aceptado del átomo era el de JJ Thomson "pudín de pasas" modelo en el cual el átomo era una gran bola de carga positiva con los pequeños electrones cargados negativamente incrustado dentro de la misma. Por aquel entonces, los físicos habían descubierto también tres tipos de radiaciones procedentes de los átomos : alfa, beta y radiación gamma. Los experimentos de 1911 realizados por Lise Meitner y Otto Hahn, y por James Chadwick en 1914 mostraron que el espectro de decaimiento beta es continuo y no discreto. Es decir, los electrones son expulsados del átomo con una gama de energías, en vez de las cantidades discretas de energía que se observa en rayos gamma y decaimiento alfa. Esto parecía indicar que la energía no se conservaba en estos decaimiento. Posteriormente se descubrió que la energía sí se conserva, con el descubrimiento de los neutrinos.En 1906 Ernest Rutherford publicó "El retraso de la partícula alfa del radio cuando atraviesa la materia", en Philosophical Magazine (12, p. 134-46). Hans Geiger amplió este trabajo en una comunicación a la Royal Society (Proc. Roy. Soc. 17 de julio de 1908) con experimentos y Rutherford se había hecho pasar aire a través de las partículas α, papel de aluminio y papel de aluminio dorado. Geiger y Marsden publicaron trabajos adicionales en 1909 (Proc. Roy. Soc. A82 p. 495-500) y ampliaron aún más el trabajo en la publicación de 1910 por Geiger (Proc. Roy. Soc. Febrero 1, 1910). En 1911-2 Rutherford explicó ante la Royal Society los experimentos y propuso la nueva teoría del núcleo atómico.

Por esas mismas fechas (1909) Ernest Rutherford realizó un experimento en el que Hans Geiger y Ernest Marsden, bajo su supervisión dispararon partículas alfa (núcleos de helio) en una delgada lámina de oro. El modelo atómico de Thomson predecía que la de las partículas alfa debían salir de la lámina con pequeñas desviaciones de sus trayectorias. Sin embargo, descubrió que algunas partículas se dispersan a grandes ángulos, e incluso completamente hacia atrás en algunos casos. Este descubrimiento en 1911, llevó al modelo atómico de Rutherford, en que el átomo está constituido por protones y electrones. Así, el átomo del nitrógeno-14 estaría constituido por 14 protones y 7 electrones.

El modelo de Rutherford funcionó bastante bien hasta que los estudios llevados a cabo por Franco Rasetti, en el Institute of Technology de California en 1929. En 1925 se sabía que los protones y electrones tiene un espín de 1 / 2, y en el modelo de Rutherford nitrógeno - 14 los 14 protones y seis de los electrones deberían cancelar sus contribuciones al espín total, estimándose un espín total de 1 / 2. Rasetti descubierto, sin embargo, que el nitrógeno - 14 tiene un espín total unidad.

En 1930 Wolfgang Pauli no pudo asistir a una reunión en Tubinga, y en su lugar envió una carta famoso con la clásica introducción "Queridos Señoras y señores radiactivos ". En su carta Pauli sugirió que tal vez existía una tercera partícula en el núcleo, que la bautizó con el nombre de "neutrones". Sugirió que era más ligero que un electrón y sin carga eléctrica, y que no interactuaba fácilmente con la materia (y por eso todavía no se le había detectado). Esta hipótesis permitía resolver tanto el problema de la conservación de la energía en la desintegración beta y el espín de nitrógeno - 14, la primera porque los neutrones llevaban la energía no detectada y el segundo porque un electrón extra se acoplaba con el electrón sobrante en el núcleo de nitrógeno - 14 para proporcionar un espín de 1. Enrico Fermi redenominó en 1931 los neutrones de Pauli como neutrinos (en italiano pequeño neutral) y unos treinta años después se demostró finalmente que un neutrinos realmente se emiten en el decaimiento beta.

En 1932 James Chadwick se dio cuenta de que la radiación que de que había sido observado por Walther Bothe, Herbert L. Becker, Irène y Jean Frédéric Joliot-Curie era en realidad debido a una partículas que él llamó el neutrón. En el mismo año Dimitri Ivanenko sugirió que los neutrones eran, de hecho partículas de espín 1 / 2, que existían en el núcleo y que no existen electrones en el mismo, y Francis Perrin sugirió que los neutrinos son partículas nucleares, que se crean durante el decaimiento beta. Fermi publicó 1934 una teoría de los neutrinos con una sólida base teórica. En el mismo año Hideki Yukawa propuso la primera teoría importante de la fuerza para explicar la forma en que el núcleo mantiene junto.

Descripción del núcleo

Forma y tamaño del núcleo

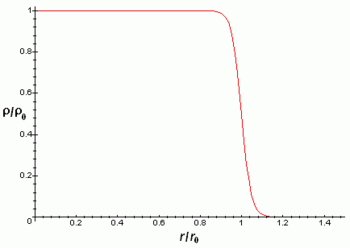

Los núcleos atómicos son mucho más pequeños que el tamaño típico de un átomo (entre 10 mil y 100 mil veces más pequeños). Además contienen más del 99% de la masa con lo cual la densidad másica del núcleo es muy elevada. Los núcleos atómicos tienen algún tipo de estructura interna, por ejemplo los neutrones y protones parecen estar orbitando unos alrededor de los otros, hecho que se manifiesta en la existencia del momento magnético nuclear. Sin embargo, los experimentos revelan que el núcleo se parece mucho a una esfera o elipsoide compacto de 10-15 m (= 1 fm), en el que la densidad parece prácticamente constante. Naturalmente el radio varía según el número de protones y neutrones, siendo los núcleos más pesados y con más partículas algo más grandes. La siguiente fórmula da el radio del núcleo en función del número de nucleones A:Donde

La densidad de carga eléctrica del núcleo es aproximadamente constante hasta la distancia

y luego decae rápidamente hasta prácticamente 0 en una distancia

y luego decae rápidamente hasta prácticamente 0 en una distancia  de acuerdo con la fórmula:

de acuerdo con la fórmula:Donde r es la distancia radial al centro del núcleo atómico.

Las aproximaciones anteriores son mejores para núcleos esféricos, aunque la mayoría de núcleos no parecen ser esféricos como revela que posean momento cuadrupular diferente de cero. Este momento cuadrupolar se manifiesta en la estructura hiperfina de los espectros atómicos y hace que el campo eléctrico del núcleo no sea un campo coulombiano con simetría esférica.

Estabilidad del núcleo

Diagrama de Segrè,

en rojo los núcleos estables, en otros colores los núcleos inestables

coloreados según el período de desintegración. Obsérvese que un ligero

exceso de neutrones favorece la estabilidad en átomos pesados.

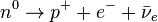

La explicación de esta estabilidad de los núcleos reside en la existencia de los piones. Aisladamente los neutrones pueden sufrir vía interacción débil la siguiente desintegración:

(1)Sin embargo, dentro del núcleo atómico la cercanía entre neutrones y protones hace que sean mucho más rápidas, vía interacción fuerte las reacciones:

(2)Esto hace que continuamente los neutrones del núcleo se transformen en protones, y algunos protones en neutrones, esto hace que la reacción () apenas tenga tiempo de acontecer, lo que explica que los neutrones de los núcleos atómicos sean mucho más estable que los neutrones aislados. Si el número de protones y neutrones se desequilibra, se abre la posibilidad de que en cada momento haya más neutrones y sea más fácil la ocurrencia de la reacción ().

Modelos de estructura del núcleo atómico

En 1808 el químico inglés John Dalton propone una nueva teoría sobre la constitución de la materia. Según Dalton toda la materia está formada por átomos indivisibles e invisibles, estos a su vez se unen para formar compuestos en proporciones enteras fijas y constantes. De hecho Dalton propuso la existencia de los átomos como una hipótesis para explicar porqué los átomos sólo se combinaban en ciertas combinaciones concretas. El estudio de esas combinaciones le llevó a poder calcular los pesos atómicos. Para Dalton la existencia del núcleo atómico era desconocida y se consideraba que no existían partes más pequeñas.En 1897 Joseph John Thomson fue el primero en proponer un modelo estructural interno del átomo. Thomson fue el primero en identificar el electrón como partícula subatómica de carga negativa y concluyó que «si los átomos contienen partículas negativas y la materia se presenta con neutralidad de carga, entonces deben existir partículas positivas». Es así como Thomson postuló que el átomo debe ser una esfera compacta positiva en la cual se encontrarían incrustados los electrones en distintos lugares, de manera que la cantidad de carga negativa sea igual a la carga positiva.

Así ni el modelo atómico de Dalton ni el de Thomson incluían ninguna descripción del núcleo atómico. La noción de núcleo atómico surgió en 1911 cuando Ernest Rutherford y sus colaboradores Hans Geiger y Ernest Marsden, utilizando un haz de radiación alfa, bombardearon hojas laminadas metálicas muy delgadas, colocando una pantalla de sulfuro de zinc a su alrededor, sustancia que tenía la cualidad de producir destellos con el choque de las partículas alfa incidentes. La hoja metálica fue atravesada por la mayoría de las partículas alfa incidentes; algunas de ellas siguieron en línea recta, otras fueron desviadas de su camino, y lo más sorprendente, muy pocas rebotaron contra la lámina.

A la luz de la fórmula dispersión usada por Rutherford:

(1)Donde:

, siendo

, siendo  la constante dieléctrica del vacío y

la constante dieléctrica del vacío y  , es la carga eléctrica del centro dispersor.

, es la carga eléctrica del centro dispersor. , es la energía cinética inicial de la partícula alfa incidente.

, es la energía cinética inicial de la partícula alfa incidente. es el parámetro de impacto.

es el parámetro de impacto.

En 1913 Niels Bohr postula que los electrones giran a grandes velocidades alrededor del núcleo atómico. Los electrones se disponen en diversas órbitas circulares, las cuales determinan diferentes niveles de energía. El electrón puede acceder a un nivel de energía superior, para lo cual necesita "absorber" energía. Para volver a su nivel de energía original es necesario que el electrón emita la energía absorbida (por ejemplo en forma de radiación).

Comúnmente existen dos modelos diferentes describir el núcleo atómico:

- El modelo de la gota de agua

- El modelo de capas

Modelo de la gota líquida

Este modelo no pretende describir la compleja estructura interna del núcleo sino sólo las energías de enlace entre neutrones y protones así como algunos aspectos de los estados excitados de un núcleo atómico que se reflejan en los espectros nucleares. Fue inicialmente propuesto por Bohr (1935) y el núcleo en analogía con una masa de fluido clásico compuesto por neutrones y protones y una fuerza central columbiana repulsiva proporcional al número de protones Z y con origen en el centro de la gota.Desde el punto de vista cuantitativo se observa que la masa de un núcleo atómico es inferior a la masa de los componentes indiviudales (protones y neutrones) que lo forman. Esta no conservación de la masa está conectada con la ecuación

de Einstein, por la cual parte de la masa está en forma de energía de

ligazón entre dichos componentes. Cuantiativamente se tiene la siguiente

ecuación:1

de Einstein, por la cual parte de la masa está en forma de energía de

ligazón entre dichos componentes. Cuantiativamente se tiene la siguiente

ecuación:1Donde:

son respectivamente la masa del núcleo, la masa de un protón y la masa de un neutrón.

son respectivamente la masa del núcleo, la masa de un protón y la masa de un neutrón. son respectivamente el número atómico (que coincide con el número de protones), el número másico (que coincide con el número de nucleones) y A-Z por tanto coincide con el número de neturones.

son respectivamente el número atómico (que coincide con el número de protones), el número másico (que coincide con el número de nucleones) y A-Z por tanto coincide con el número de neturones. es la energía de enlace entre todos los nucleones.

es la energía de enlace entre todos los nucleones.

Donde:

este término representa el efecto favorable del volumen.

este término representa el efecto favorable del volumen. este término representa el efecto desfavorable de la superficie.

este término representa el efecto desfavorable de la superficie. representa el efecto de la repulsión coulombiana entre protones.

representa el efecto de la repulsión coulombiana entre protones. representa el hecho de que los núcleos "equilibrados" con un número similar de protones y neutrones son más estables.

representa el hecho de que los núcleos "equilibrados" con un número similar de protones y neutrones son más estables. representa el hecho de que los núcleos con un número par de protones y

neutrones, son más estables que los que tienen un número impar de ambas

especies. Matemáticamente el término viene dado por:

representa el hecho de que los núcleos con un número par de protones y

neutrones, son más estables que los que tienen un número impar de ambas

especies. Matemáticamente el término viene dado por:

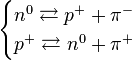

En física nuclear, fusión nuclear es el proceso por el cual varios núcleos atómicos de carga similar se unen y forman un núcleo más pesado. Simultáneamente se libera o absorbe una cantidad enorme de energía, que permite a la materia entrar en un estado plasmático.

La fusión de dos núcleos de menor masa que el hierro (en este elemento y en el níquel ocurre la mayor energía de enlace nuclear por nucleón) libera energía en general. Por el contrario, la fusión de núcleos más pesados que el hierro absorbe energía. En el proceso inverso, la fisión nuclear, estos fenómenos suceden en sentidos opuestos.

En el caso más simple de fusión, en el hidrógeno, dos protones deben acercarse lo suficiente para que la interacción nuclear fuerte pueda superar su repulsión eléctrica mutua y obtener la posterior liberación de energía.

En la naturaleza ocurre fusión nuclear en las estrellas, incluido el Sol. En su interior las temperaturas son cercanas a 15 millones de grados Celsius.1 Por ello a las reacciones de fusión se les denomina termonucleares. En varias empresas se ha logrado también la fusión (artificial), aunque todavía no ha sido totalmente controlada.

Sobre la base de los experimentos de transmutación nuclear de Ernest Rutherford, conducidos pocos años antes, Mark Oliphant, en 1932, observó por primera vez la fusión de núcleos ligeros (isótopos de hidrógeno).

Posteriormente, durante el resto de ese decenio, Hans Bethe estudió las etapas del ciclo principal de la fusión nuclear en las estrellas.

La investigación acerca de la fusión para fines militares se inició en la década de 1940 como parte del Proyecto Manhattan, pero no tuvo éxito hasta 1952. La indagación relativa a fusión controlada con fines civiles se inició en la década de 1950, y continúa hasta el presente.

Requisitos

Para que pueda ocurrir la fusión debe superarse una importante barrera de energía producida por la fuerza electrostática. A grandes distancias, dos núcleos se repelen debido a la fuerza de repulsión electrostática entre sus protones, cargados positivamente.Sin embargo, si se pueden acercar dos núcleos lo suficiente, debido a la interacción nuclear fuerte, que en distancias cortas es mayor, se puede superar la repulsión electrostática.

Cuando un nucleón (protón o neutrón) se añade a un núcleo, la fuerza nuclear atrae a otros nucleones, pero -debido al corto alcance de esta fuerza- principalmente a sus vecinos inmediatos. Los nucleones del interior de un núcleo tienen más vecinos nucleones que los existentes en la superficie.

Ya que la relación entre área de superficie y volumen de los núcleos menores es mayor, por lo general la energía de enlace por nucleón debido a la fuerza nuclear aumenta según el tamaño del núcleo, pero se aproxima a un valor límite correspondiente al de un núcleo cuyo diámetro equivalga al de casi cuatro nucleones.

Por otra parte, la fuerza electrostática es inversa al cuadrado de la distancia. Así, a un protón añadido a un núcleo le afectará una repulsión electrostática de todos los otros protones.

Por tanto, debido a la fuerza electrostática, cuando los núcleos se hacen más grandes, la energía electrostática por nucleón aumenta sin límite.

Finalmente la energía de enlace nuclear se convierte en negativa, y los núcleos más pesados (con más de 208 nucleones, correspondientes a un diámetro de alrededor de seis nucleones) no son estables.

Cuatro núcleos muy estrechamente unidos, en orden decreciente de energía de enlace nuclear, son 62Ni, 58Fe, 56Fe, y 60Ni.2 A pesar de que el isótopo de níquel 62Ni es más estable, el isótopo de hierro 56Fe es una orden de magnitud más común. Esto se debe a mayor tasa de desintegración de 62Ni en el interior de las estrellas, impulsada por absorción de fotones.

Una notable excepción a esta tendencia general es el núcleo helio 4He, cuya energía de enlace es mayor que la del litio, el siguiente elemento por incremento de peso.